Noch lange nicht fertig

Beim Kirchentag in Nürnberg erregte ein durch Künstliche Intelligenz (KI) generierter Gottesdienst Aufsehen. Ausgehend davon skizzieren die beiden Erlanger Theologieprofessoren Peter Dabrock und Florian Höhne in ihrem Text die grundlegenden Herausforderungen, die KI für das Feld der Religion bereithält. Sie zeigen auf, welche ethischen und sozialen Standards dabei unbedingt zu wahren sind.

Die folgenden Worte hätten so auch aus dem Mund einer Pfarrperson kommen können: „Zeit ist ein kostbares Gut, das wir in unserem hektischen Leben oft als selbstverständlich ansehen. Aber lassen Sie uns in diesem Moment innehalten und über die Bedeutung dieses Treffens nachdenken. Wir sind zusammengekommen, um […].“

Diese Worte erklangen am 9. Juni in Fürth während des Kirchentages, bei dem, was seitdem als erster KI-Gottesdienst diskutiert wird: vorgetragen von einer menschlich, leicht maschinell klingenden Stimme, dazu das Bild eines weiblichen Avatars auf der Leinwand, dessen Lippen sich passend zur Sprache bewegen. Stimme und Bild auf der Leinwand wechseln im Verlauf des KI-Gottesdienstes, zur Predigt über Philipper 3,13–14 ist der Avatar als eine Person of Color dargestellt. In der Predigt geht es auch um die Ethik der KI selbst; es ist von Gerechtigkeit und Gemeinwohl die Rede und zu hören: „Wir müssen uns dafür einsetzen, dass die Technologie so entwickelt und eingesetzt wird, dass sie mit unseren Werten übereinstimmt und allen zugutekommt – nicht nur einigen wenigen.“

KI-generierte Begrüßung, Kyrie, Bekenntnis, Bibeltext und Predigt mit ethischer Selbstreflexion – so faszinierend das technisch Mögliche hier ist, so hinterlässt es doch Unbehagen, Ernüchterung und Fragen. Auf dem Internetportal der Nürnberger Nachrichten wird resümiert: „Besonders gut an kam das Ergebnis nicht.“ Die Gottesdienstrezension in chrismon titelt „Der Funke springt nicht über.“ Und die taz sieht vor allem Fragen aufgeworfen: „Wer spricht, wenn die KI von ‚Wir‘ und ‚Ich‘ spricht? […] Und kann KI vielleicht eine Lösung für unbesetzte Pfarrstellen auf dem Land sein?“

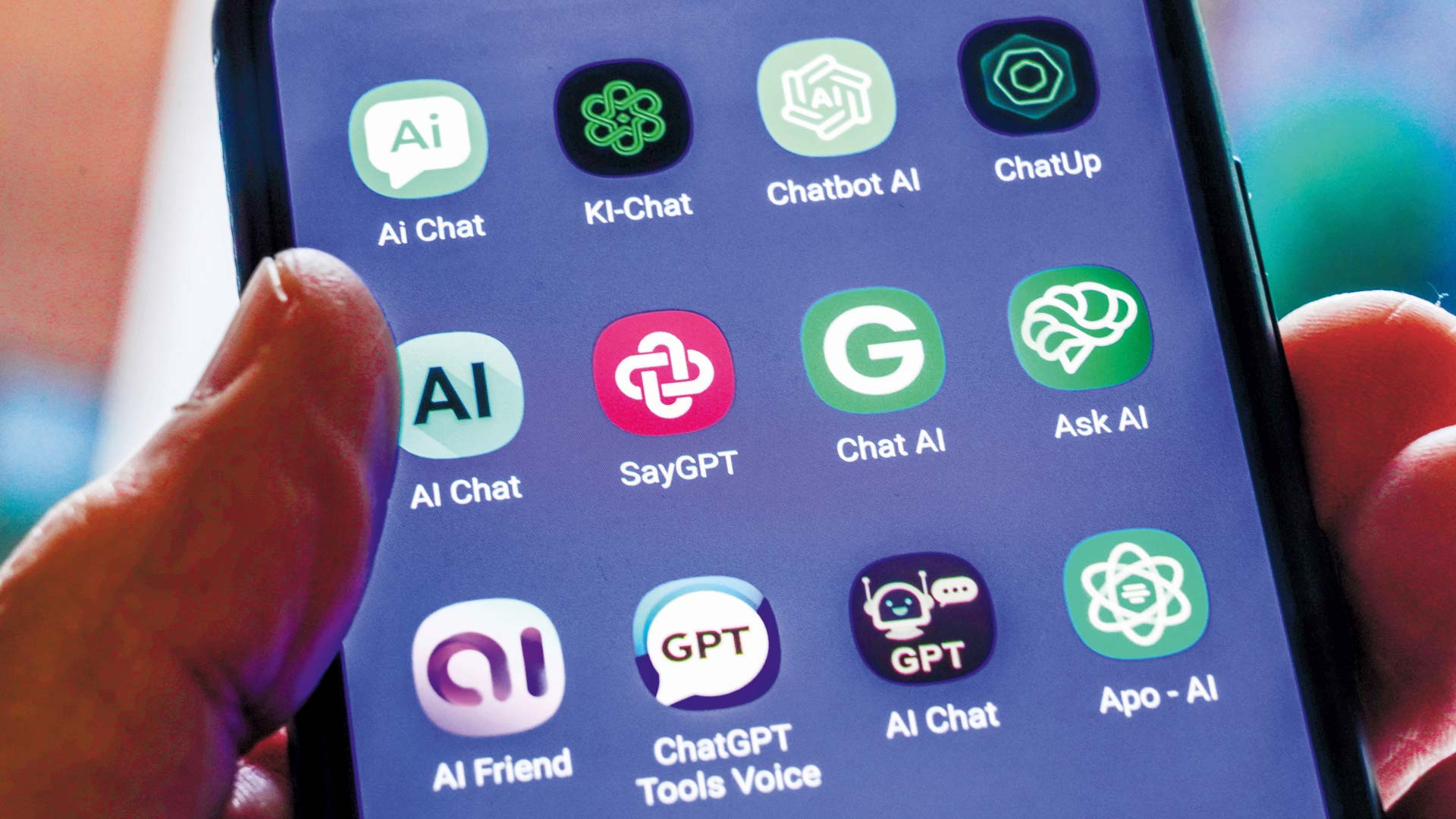

Gerade die letzte Frage wird in der gegenwärtigen kirchlichen Lage bei vielen das Unbehagen verstärken – und für andere geradezu verführerisch klingen. Das macht es umso nötiger, grundsätzlich zu fragen: Sind so genannte Künstliche Intelligenzen, vor allem ihr gegenwärtig gehypter Spross, die großen Sprachmodelle, von denen besonders ChatGPT in aller Munde ist, eine Gefahr für die Religion, oder können sie diese sogar stärken? Versuchen wir einen Schritt zurückzutreten, um die Herausforderungen von ChatGPT für die Religionspraxis besser zu begreifen. Dafür muss zunächst ansatzweise geklärt sein, was man denn unter Religion im Allgemeinen und der christlichen Religionskultur im Besonderen versteht.

Offen für Kompassion

„Kürzeste Definition von Religion: Unterbrechung!“, so formulierte es pointiert der katholische Theologe Johann Baptist Metz (1928–2019). Damit bringt er ein bedenkenswertes Ideal von Religion auf den Punkt: Religion reiße uns aus dem Gewohnten, durchbreche etablierte soziale und kulturelle Machtstrukturen, lasse vielmehr Altbekanntes neu sehen, überrasche damit ständig, sensibilisiere für das Leid der Unterdrückten und öffne so für eine Kompassion, sprich: ein menschlicheres Leben miteinander – all dies verstanden primär als Verheißung und Ermutigung, sekundär als Verpflichtung und Ermahnung. Metz macht diese Idealversion von Religion fest an der Botschaft des Gottes, der in der religiösen Erfahrungsbibliothek, der Bibel, bezeugt wird: dem Gott, der Menschen ins Dasein ruft, ein randständiges Volk zu seinem Bundespartner erhebt, aus der Knechtschaft befreit, ihm trotz aller Untreue immer wieder die Treue hält und sich so mit Jesus von Nazareth über den Tod hinaus identifiziert, dass in ihm all die Anwaltschaft für das Endliche, Verletzliche, Schwache als universale Botschaft für die ganze Welt besiegelt wird. Am Ende trägt die Hoffnung, dass das Leben in Fülle gegenüber allen lebensfeindlichen Mächten siegen wird.

Geht man mit diesem Verständnis von Religion an ChatGPT, so kann das KI-Modell zunächst als Unterbrechung erscheinen. Für die Gemeinde unterbricht etwa der Fürther KI-Gottesdienst die Gewohnheiten ihres Mitfeierns, Mitsingens, Sich-Einstimmens; der KI-generierte Text der Predigt mag manch Bild vom genialen Prediger ernüchternd unterbrechen. Aber aufs Ganze gesehen sind dies insofern keine Unterbrechungen im Metz’schen Sinne, als sie etablierte Machtstrukturen gerade nicht unterbrechen, als sie befremden, ohne für das Leid anderer zu sensibilisieren. Das KI-Modell bewirkt eher noch das Gegenteil von Unterbrechung: Es – so heißt es immer wieder – kenne nicht wirklich Neues, reproduziere vermeintlich Kreatives nur aus der Vielzahl von ihm Vorgelegten und Verarbeiteten: Kreativitätsmimikry statt Kreativität.

So richtig, so wenig beruhigend. Kaum anders verhält es sich ja bei uns Menschen. Auch wir machen Erfahrungen, wir unterhalten uns, verinnerlichen Erlerntes und bilden aus diesem Pool unsere Weltsicht und -orientierung. Nur, dass ChatGPT vermutlich deutlich mehr kulturelle Informationen verarbeiten kann als unsereins. Das KI-System gewinnt Bedeutung nur aus der Wahrscheinlichkeitsvoraussage des nächsten Wortes; das ist nicht zu verwechseln mit menschlichen Bedeutungsurteilen, die einem Sachverhalt, einer Person aus und in einem Kontext kognitiv, emotional und sozial Bedeutung zuerkennt – aber es ist eine, wenn auch eigentümliche Art, Bedeutung zu schaffen.

Vorurteile gefestigt

Das signalisiert zweierlei. Erstens: Gewinnt sogenannte KI Bedeutung nur aus Wahrscheinlichkeitsvoraussagen, steht auch der Wiederholung und Verbreitung von stereotypen oder ausgrenzenden Bedeutungen wenig entgegen, wenn die – freilich selbst wieder ambivalente – menschliche Urteilskraft nicht erneut interveniert. Die US-amerikanische Internetforscherin Safiya Noble hat in ihrem Buch Algorithms of Opression bereits 2018 ausführlich beschrieben, wie sich in Arbeitsweisen und Ergebnissen von Suchmaschinen Rassismen und Sexismen wiederfinden. In KI-gestützt aufbereiteten, verfassten und geschaffenen Text- und Bildwelten begegnen Menschen zunächst auch ihren eigenen Vorurteilswelten – oder genauer: den Vorurteilen der jeweiligen Mehrheit der Nutzer:innen – gerade solche Beheimatung in diesen Vorurteilswelten würde durch eine Religion als Unterbrechung aber unterbrochen werden müssen.

Zweitens signalisiert besagte Bedeutungsgewinnung: So schnell werden wir mit dem KI-Modell nicht fertig, jetzt nicht und in Zukunft erst recht nicht, denn sie versprechen, noch viel besser zu werden. Ob wirklich Neues, vom Philosophen Alfred Schütz (1899–1959) einmal, in Abgrenzung gegenüber dem nur vermeintlich Neuen, Neuartiges genannt, entsteht oder nur eine gute Mischung aus Bekanntem, ist gar nicht so leicht zu identifizieren. Gelingt es einem aber, der KI clevere Fragen zu stellen, dann wundert man sich, wie auf den ersten Blick kreative Antworten produziert werden – auch solche, denen das Charakteristikum „überraschend“ oder „unterbrechend“ zuerkannt werden kann.

Anders gesagt: ChatGPT kann religiöse Erfahrung und Lebensform unterstützen, wenn man darin schlicht ein Instrument für diese menschliche Praktik sieht. Das heißt ganz unprätentiös: Natürlich lässt sich ChatGPT auch für Predigtvorbereitung benutzen – so wie Predigende bisher auch schon auf Texte, Anregungen und Predigthilfen zurückgreifen. Es muss halt passen; passen gegenüber der Predigtgemeinde – und vor allem angesichts der eigenen Persönlichkeit. Und es bleibt die Letztverantwortung der Predigtperson, was sie sagt. Wenn alle merken: Hier redet jemand unwahrhaftig, dann ist Einhalt geboten – nicht anders als bei der abgelesenen Lesepredigt.

Kurzum: Ob ChatGPT religionsaffin unterbricht, hängt schlicht an seinem Gebrauch. Man kann dem Instrumentarium nicht trauen – es spinnt sich ja nach dem Motto „Hauptsache, der Satz kommt zu einem Punkt“ auch die wildesten Sachen zusammen und kann beispielsweise frei fabulierend vermeintlich sinnvoll erscheinende Beiträge über Bücher oder Personen schreiben, die es nicht gibt; in der Fachsprache sagt man: Die KI „halluziniert“. Es sollte sich herumgesprochen haben, ist aber nicht spezifisch für seine potenzielle Religionsaffinität.

Sind ChatGPT & Co. nun Chance oder Gefahr für Religionspraktiken? Das lässt sich noch an einem anderen Religionsverständnis durchspielen, das weniger idealistisch fokussiert ist als das Metz‘sche. Religion ist danach nicht nur Unterbrechung, sondern auch Beheimatung, Lebensform, Kontingenzbewältigung und Sinnstiftung angesichts all der Widerfahrnisse, die das Leben für den Einzelnen, für Gemeinschaften und die Gesellschaft bereithält. Könnte ChatGPT nicht genau dies bestärken, indem es den religiösen Menschen im Kosmos seiner Erwartungen und Erwartungserwartungen hält und so Beheimatung anbietet?

Dieser eher spirituell-bestärkende Einsatz von KI-Lösungen in der Religion bleibt blass bis gefährlich oder gar sozial ungerecht. Blass, wie das anfangs erwähnte Beispiel der Fürther-KI-Liturgie zeigt. So hatte die Rundfunkbeauftragte der bayerischen Landeskirche, Melitta Müller-Hansen, etwa die fehlende Dramaturgie, Tiefe und Sprachkunst kritisiert. Gefährlich würde es, wenn eine KI als Seelsorgeangebot in konkreten Krisensituationen eingesetzt würde. Man mag sich vorstellen, dass Sprachbots – ähnlich wie Psychoratgeberhefte – generisch Orientierung für bestimmte Lebenslagen anbieten; immer müsste jedoch – ethisch betrachtet – zum einen deutlich gemacht werden, dass man mit einer KI und nicht mit einem Menschen kommuniziert, und zum anderen dürften keine ganz konkreten Ratschläge erteilt werden. Wie zynisch wäre es, in existenziell dramatischen Lebenslagen mit einem Wahrscheinlichkeitsgenerator abgespeist zu werden! Sozial ungerecht könnte es werden, wenn KI-Modelle künftig zum Einsparen von (teurerem) Personal genutzt würden, wenn es also zur Geld- oder Wohnortfrage würde, ob einem ein menschliches Gegenüber – in der Schule, in der Psychotherapie, in Seelsorge und Beratung oder gar im Gottesdienst – begegnet oder ob man mit dem „billigeren“ Sprachmodell vorliebnehmen muss.

Hochmut, Trägheit, Lüge

Blickt man vor dem Hintergrund des bisher Gesagten auf die zwei skizzierten Zugänge zu Religion – Religion als Unterbrechung oder als Beheimatung –, gilt es, mit Karl Barth drei Varianten menschlicher Selbstverfehlung zu vermeiden, wenn ChatGPT im Kontext der Religionspraxis verwendet wird: Hochmut, Trägheit, Lüge. Dem Hochmut verfällt man dort, wo man in der Technik einen Lösungsweg identifiziert, um Unterbrechung oder Beheimatung auf Knopfdruck herbeizuzaubern, und dabei den sozialen und kulturellen Kontext mit seinen Gerechtigkeitsfragen ausblendet. Es wäre die Falle der Werkgerechtigkeit, in die man hineintappen würde. Denn noch in der religiösen Beheimatung muss Unterbrechung möglich sein – wozu sonst wöchentlich einer Predigt lauschen? – und in der Unterbrechung darf es Heimat-Sehnsucht geben: Die Matthäuspassion von Bach darf ich als (religions-)kulturellen Hafen in eigenen Erfahrungserfahrungen schätzen. Umgekehrt: Träge ist der Mensch dort, wo er auf billige Gnade setzt, wo er nicht ob des eigenen Heils, aber ohne Blick für das Gedeihen der Nächsten alles Experimentelle in der Religionspraxis vermeidet und gemäß Paragraph sechs des Kölschen Grundgesetzes: „Kenne mer nit, bruche mer nit, fott domet.“

Aber ob KI irgendwo instrumentell sinnvoll eingesetzt werden kann oder ob sie größere Transformationen im Sinne von Hochmut oder Trägheit bewirkt, hängt davon ab, ob man nicht in den dritten Modus der Selbstverfehlung, der Lüge, verfällt und über etwas sagt, dass es etwas ist, was es nicht ist. Aber wie vermeidet man Hochmut, Trägheit, Lüge? Tugendethisch könnte man antworten: mit Nüchternheit, Offenheit und Wahrhaftigkeit. Kurzum: die Kontraria zu Hochmut, Trägheit und Lüge suchen. Sozialethisch könnte man antworten: durch gerechtere Strukturen, durch Partizipation an (technik-)politischen Entscheidungsprozessen, durch Zugang zu Medienkompetenz, Tugendbildung und Existenzsicherung, durch die Menschen sich nüchterne Experimentierfreude und nachdenklich-wahrhaftige Distanz leisten können.

Was all dies auf einer höheren Ebene verbindet, ist die (Ermöglichung von) Responsivität, die durch Hochmut, Trägheit und Lüge zerstört wird. Responsivität ist mehr als die weichgespülte Resonanz à la Hartmut Rosa. Anders als diese ist sie zunächst die Erfahrung, sich im Eigenen durch Fremdes bestimmen zu lassen, die Erfahrung und dann die Reflexion auf die Erfahrung des von Anderen her immer wieder sich herausgefordert zu sehen und neu zu werden. Ob dieses Unterbrochen-Werden zu einer neuen, höheren, gar mit sich versöhnten Form von Identität führt, ist vor der jeweiligen Begegnung mit einem Fremdem alles andere als ausgemacht. Responsivität ereignet sich. Im besten Fall dient ihr eine Lebenseinstellung, die offen ist für Selbsthinterfragen aufgrund von Zweideutigkeitsoffenheit, aufgrund von Differenzbewusstsein – kurzum: eine Suche nach Bildung. Ob dies zu responsiven Ereignissen führt, ist im Vorhinein nicht ausgemacht.

Aber wenn die so verstandene Bildung wohl der Schlüssel zum souveränen wie selbstkritischen Umgang mit ChatGPT sein wird, dann muss jede theologische Deutung dieser sich andeutenden Transformation menschlicher Kommunikation ihre sozialethische Saite zum Schwingen bringen. Wie wird gewährleistet, dass in Bildungseinrichtungen, aber auch in kirchlicher Kommunikation Lesen und vor allem selbstständiges Schreiben als Kulturtechniken gefördert werden und durch die schnellen Erfolg versprechenden KI-Techniken nicht der Gap weiter zunimmt zwischen denen, die einen soliden Hintergrund für fokussierte Verwendung von ChatGPT besitzen, und allen anderen?

Wenn man liest, dass der Prompt Engineer (also der Ingenieur, der ChatGPT clevere Fragen stellen kann) als ein Trendberuf der näheren Zukunft mit hohem Gehalt eingeschätzt wird, sieht man, welches Ungleichheitspotenzial in der Nutzungskompetenz dieser Techniken steckt. Zugleich wird die Seite derjenigen, die die Chancen von ChatGPT fördern, aber die sachlichen und sozialen Risiken im Blick behalten wollen, nach Wegen mitsuchen müssen, wie die in Europa unter anderem durch den AI Act begonnene, aber noch längst nicht abgeschlossene Regulierung dieser disruptiven Technologien voranzubringen ist. Diese Aufgabe dürfte neben der Bewältigung der Klimakrise eine der Herkulesaufgaben unserer Zeit sein. Wenn sich die Kirchen als zivilgesellschaftliche Akteure – im Übrigen als einer der wenigen zivilgesellschaftlichen Akteure, die ein globales Netzwerk besitzen – hierbei einbringen wollen, müssen sie (viel mehr) Sorge dafür tragen, dass keine neuen unüberwindbar erscheinenden digitalen Gaps verstärkt werden, dass die Einzelnen gegenüber den großen Akteuren im Feld nicht vollends abgehängt werden und rechtlos bleiben und dass die Geheimnishaftigkeit der Menschen – ob ihrer Würde wie Verletzlichkeit – gewahrt bleibt, damit Freiheit nicht (noch mehr) zu einer Worthülse verkommt.

Responsivität kultivieren

Zurück zum KI-Gottesdienst in Fürth: Religion muss schauen, dass sie im Sinne von Kohelet 3 („Alles hat seine Zeit …“) zur rechten Zeit den rechten Ton trifft. Das geschieht oft dort, wo Erwartungen durchbrochen werden. Noch schafft KI keine religiöse Atmosphäre – dass das irgendwann technisch möglich und sozial gewünscht wird, ist gar nicht ausgeschlossen, beispielsweise stehen wir erst ganz am Anfang des Metaverse und anderer inversiver Technologien, die solche Erfahrungen versprechen. Deshalb lohnt es sich, religiös kriterial und kritisch an die KI-Technologien heranzugehen, damit Responsivität kultiviert wird, die Technikinnovation Ungerechtigkeiten mindestens nicht verschärft und die Balance zwischen Unterbrechung und Beheimatung gewahrt bleibt.

Peter Dabrock

Peter Dabrock ist seit 2010 Professor für Systematische Theologie mit dem Schwerpunkt Ethik an der Friedrich-Alexander-Universität Erlangen-Nürnberg. Von 2012 bis 2020 war Dabrock Mitglied des Deutschen Ethikrates und von 2016 bis 2020 dessen Vorsitzender.

Florian Höhne

Dr. Florian Höhne ist seit 2023 Professor für Medienkommunikation, Medienethik und Digitale Theologie an der Friedrich-Alexander-Universität Erlangen-Nürnberg.